Umělá inteligence Googlu se zase vytahuje. Mluví jako člověk, skládá vážnou hudbu

- Články

-

Daniel Macho

- 12.9.2016

- 2

V minulosti jsme již několikrát psali o úspěších umělé inteligence. Jednou to byla umělá inteligence IBM jménem Watson, jindy zase ta od Googlu. Pokaždé ale předvedla něco, co dosud počítač sám od sebe nedovedl. V minulosti jsme Googlí AI mohli třeba vidět skládat temnou až děsivou poezii (psali jsme v článku AI Googlu přečetla tisíce románů. Nyní se dala na jejich psaní), Watsona řídit autobus či skládat filmové trailery. Nyní se Google chlubí tím, že jeho AI umí mluvit jako člověk a skládat dobře znějící klavírní hudbu.

Umělá inteligence Googlu nemá strojový hlas

Googlem vlastněná společnost DeepMind, zabývající se právě umělou inteligencí předvedla hlubokou neuronovou síť, která úžasně generuje lidskou řeč. Tato síť, kterou prozatím nazvali WaveNet, představuje významný pokrok, oproti současným hlasovým syntetizérům. DeepMind tvrdí, že projev WaveNetu vyplňuje mezeru mezi parametrickým (současně nejpoupoužívanějším) projevem a reálným lidským projevem až o více než 50%.

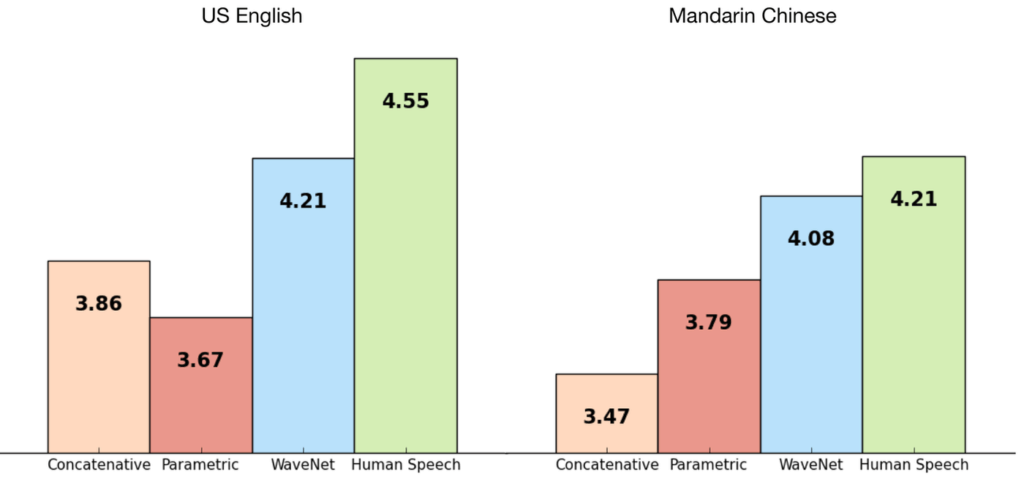

Google tedy udělal výzkum na 500 nic netušících jednotlivcích. Celý výzkum byl proveden ve dvou jazycích – v americké angličtině a mandarínské čínštině. Testovaní dostávali k poslechu hlasové ukázky a jejich úkolem bylo obodovat hlasový projev. Opravdový lidský hlas měl rovných pět bodů, což tedy bylo maximální možné bodové ohodnocení. V angličtině získal parametrický TTS (běžně používaný ve službách Googlu) průměrné ohodnocení 3,67. Konkatenativní TTS (používaný Siri od Applu) získal průměrně o něco více, 3,86 bodu. WaveNet se ale ani profesionálkou Siri nenechala zaskočit a přišla s průměrným výsledkem 4,21 bodu. V mandarínské čínštině sice dopadly výsledky značně jinak, ale WaveNet byla stále o mnoho napřed před parametrickým i konkatenativním projevem.

V čem se WaveNet liší?

Hlavním rozdílem je, že WaveNet může přímo modulovat syrový průběh audiosignálu, což je tak náročný proces, že k němu byla nutná právě samostatná neuronová síť. WaveNet se učí z nahrávek lidského hlasu a poté získané znalosti aplikuje sama na svůj vlastní výstup. A právě tato nezávislost pak programu umožňuje tvořit i jiné druhy zvuku, například hudbu.

Aby DeepMind a Google podpořili svá tvrzení, dodávají ve své studii několik zvukových vzorků, které můžete mezi sebou sami porovnat. K dispozici máme dvě věty, pokaždé vyřčenou jak parametrickým TTS, tak i WaveNetem.

Věta první:

Věta druhá:

Poté, co byla neuronová umělá inteligence Googlu vyškolena hudbou, začala produkovat zajímavé klavírní melodie. I ty si můžete poslechnout:

Ptáte se jaké mohou být z WaveNetu a jeho umu důsledky? Kromě toho, že bude snazší mluvit s našimi případnými robotickými vládci, by z toho mohli prospěch především naši virtuální asistenti, ať už Google Asistent, Siri nebo Cortana. Tento úspěch mimo jiný opět dokazuje potenciál neuronových sítí, které mouhou a jsou používány v rozpoznání rukopisu, vyhledávání obrázků, překladů či boji proti podvodům nebo spamu.

Google’s Deep Mind Explained! – Self Learning A.I.

Pokud by vás zajímaly detaily o neuronové síti WaveNet, můžete nahlédnout do PDF, které Google nechal zapsat jako součást studie.

Zdroj: bigthink.com

Komentáře (2)

Přidat komentář