Spory ohledně Llama 4: Podvod s benchmarky? Meta spekulace odmítá, ale smíšené chování modelů jí do karet moc nehraje

- Meta nedávno vypustila nové stádo AI modelů Llama 4 - teď už stíhá čelit podezření

- Údajně měla modely učit na testovacích sadách, což by znehodnotilo výsledky benchmarků

- Tápete v tom, co je benchmark, a zajímá vás, jak na to Meta reagovala? To vše v článku vysvětlíme

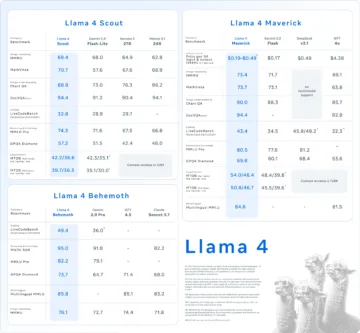

V AI světě není benchmark jen test. Je to často vstupenka do prestižního srovnání, titulek, PR nástroj – a někdy i zdroj podezření. Přesně to se aktuálně děje s novými modely Llama 4 od společnosti Meta, konkrétně s verzemi Maverick a Scout. O víkendu se na sociálních sítích – především na X a Redditu – začaly šířit neověřené spekulace, že Meta modely „učila“ na testovacích sadách.

To by znamenalo, že výsledky benchmarků nejsou zcela férové, protože by si model Llama 4 „pamatoval“ správné odpovědi ještě z tréninku.

Testovací sady slouží při vývoji modelů výhradně k nezávislému ověření kvality, až když je trénink hotový. Pokud by se na nich model trénoval, výsledky by mohly být výrazně nadhodnocené – a to je v rámci AI výzkumu i byznysu vnímáno velmi negativně.

Moment! Co je to vlastně benchmark?

Benchmark je v podstatě standardizovaný test, který se používá k porovnání výkonu různých AI modelů. Ve světě umělé inteligence se používají benchmarky pro různé typy úloh – třeba porozumění textu, logické myšlení, překlady, psaní kódu nebo odpovídání na otázky.

Mezi známé benchmarky patří například MMLU, GSM8K, HumanEval, ARC nebo právě LM Arena, kde se testoval i Llama 4 Maverick.

Kde se podezření ohledně skutečného výkonu Llama4 vlastně vzalo?

Zdroj původní fámy není 100% jasný, ale podle dostupných informací mohla začít na čínské sociální síti, kde anonymní uživatel tvrdil, že z Meta odešel na protest proti způsobu testování. Od té chvíle se spekulace šíří dál. Originální znění by mělo vypadat takto (překlad zhotovil Tony Peng na síti SubStack):

Pochybnosti posílila i skutečnost, že Meta použila nevydanou experimentální verzi Mavericka pro dosažení lepších výsledků v benchmarku LM Arena – zatímco veřejně dostupný model se chová znatelně jinak. Ostatně, můžete si Mavericka vyzkoušet i sami.

Jak na to vše reaguje Meta?

Meta má jasno – prostě to není pravda.

Na spekulace v pondělí zareagoval přímo Ahmad Al-Dahle, viceprezident pro generativní AI ve společnosti Meta. Na síti X uvedl, že „to jednoduše není pravda“ a že Llama 4 Scout ani Maverick nebyly trénovány na testovacích datech.

Al-Dahle sice fámy popřel, ale zároveň připustil, že uživatelé hlásí smíšenou kvalitu chování modelů – zejména podle toho, na jaké cloudové platformě jsou spuštěny. Meta podle něj pokračuje v ladění, opravách chyb a práci s partnery, kteří modely integrovali.

Co si myslíte vy? Přehání komunita, nebo Meta opravdu přestřelila?

Zdroj: TechCrunch, Reddit

O autorovi

Pavlína Čížková

Pája nemálo kdy slýchá, že vypadá, jako by do přítomnosti přišla z cyberpunkového budoucna. Nejen svou prezentací, ale i svými zájmy dává veřejnosti každý den… Více o autorovi

Mohlo by vás zajímat

Android Auto dostane schopnějšího asistenta! Takto (zhruba) vypadá Gemini v akci

Fotky Google dají uživatelům větší kontrolu, chyby AI půjde opravit